performance Blog

Die 10 häufigsten SEO-Fehler und wie man sie vermeidet

Top 10 SEO-Fehler, die jedes Unternehmen vermeiden sollte

Sie können sich nicht erklären, warum Sie mit Ihren Fokus-Keywords in Google nicht auf Platz 1 ranken? Vielleicht hat sich während der Suchmaschinenoptimierung ein Fehler eingeschlichen, der die Crawler auf Irrwege führt. Von kleinen lokalen Unternehmen bis hin zu großen Firmen: Viele Websites weisen ähnliche SEO-Fehler auf, die die Rankings und dementsprechend auch den Traffic negativ beeinflussen. Hier geben wir Ihnen einen Überblick über die SEO-Probleme, auf die wir am häufigsten stoßen. Überprüfen Sie diese Liste und stellen Sie sicher, dass Sie keinen dieser Fehler machen!

1. Die Google Search Console wird nicht genutzt

Die Google Search Console ist eines der leistungsstärksten kostenlosen SEO-Tools auf dem Markt. Aber viele Website-Besitzer nutzen das Tool nicht, obwohl es viel mehr als nur die Anzahl der Klicks und Impressions liefern kann. Die Google Search Console (zuvor Google Webmaster-Tools) ist ein kostenloser Service von Google, mit dem Sie die Darstellung Ihrer Website in den Suchergebnissen überwachen und Fehler beheben können. Verwenden Sie das Tool, um technische Fehler zu finden, Backlinks anzuzeigen, Sitemaps einzureichen und vieles mehr. Anstatt zu raten, was falsch sein könnte und wieso Sie nicht so viel SEO Traffic generieren, wie Sie könnten, nutzen Sie das Feedback, dass Google Ihnen direkt zur Verfügung stellt.

2. Die Sitemap wird nicht gefunden

XML-Sitemaps helfen Suchmaschinen wie Google dabei, Ihre Seiten intelligenter zu crawlen. Sie teilen den Crawlern mit, wo sich Ihre wichtigen Seiten befinden und liefern sogar Informationen, z. B. wann Ihre Seiten zuletzt aktualisiert wurden. Fehlende Sitemaps erschweren es Google, die Seiten zu erkunden, zu durchsuchen und zu indexieren. Folglich können Fehler in XML-Sitemaps verwirrende Signale an Google senden. Diese Fehler können dazu führen, dass Google Ihre wichtigen Seiten verpasst oder Zeit mit dem Crawlen unwichtiger Seiten verschwendet. Generell müssen Sie darauf achten, dass Ihre XML-Sitemap nur die aktuellen Seiten enthält, die mit einem HTTP 200 OK-Statuscode antworten (also keine 404-Fehler-Seiten, keine weitergeleiteten Seiten, keine Seiten mit Meta Noindex Tag etc.). Darüber hinaus sollte eine Verlinkung der Sitemap.xml aus der robots.txt-Datei bestehen. Das Fehlen einer Sitemap.xml-Datei in Ihrer robots.txt-Datei kann zum Beispiel dazu führen, dass Suchmaschinen-Crawler Ihre Website-Architektur falsch interpretieren.

3. URLs werden in robots.txt blockiert

Die robots.txt ist ein entscheidendes Tool im Arsenal eines SEOs, das dazu dient, Regeln aufzustellen, die Crawler und Roboter darüber informieren, welche Bereiche einer Website gecrawlt werden sollen und welche nicht. robots.txt-Datei besitzt eine große Macht, denn schon ein kleiner Fehler in der Datei kann eine ganze Website möglicherweise von Google deindexieren. Das erste, was Sie mit Ihrer robots.txt-Datei tun müssen, ist sicherzustellen, dass sie keine Fehler beinhaltet und dass die wichtigen Seiten nicht vom Crawling ausgeschlossen sind. Das Ausschließen unternehmensrelevanter URLs führt zu Ranking- und daraus resultierend Traffic-Einbußen.

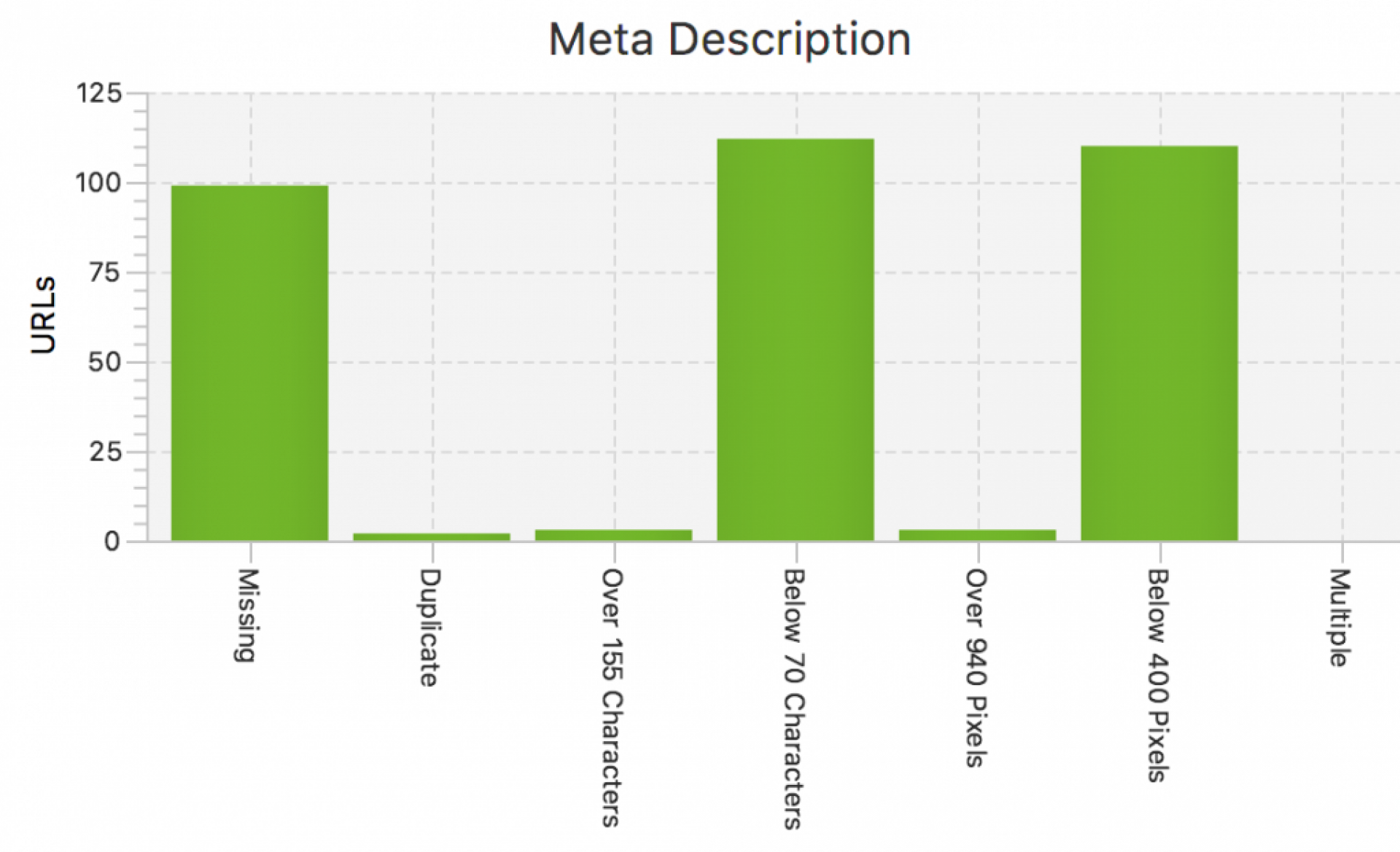

4. Meta Title und Descriptions-Tags werden ignoriert

Das -Tag leer zu lassen, ist ebenfalls ein sehr großer Fehler. Dies ist einer der wichtigsten Orte, um das Hauptkeyword zu platzieren, denn es hilft nicht nur bei der SEO-Optimierung, sondern der Text aus dem -Tag wird in den Suchergebnissen als Ihr Seitentitel angezeigt und ist somit der Erstkontakt des Users mit Ihrer Seite. Das Title-Tag gilt zugleich als einer der wichtigsten Ranking-Faktoren. Fehlt es, kann sich dies auf die Suchmaschinenplatzierung und die Klickrate in den Suchergebnissen auswirken. Auch eine fehlende Meta Description hat einen negativen Impact: Gut geschriebene Meta-Beschreibungen helfen Google, die Relevanz zu verstehen und ermutigen die Nutzer, auf das Ergebnis zu klicken. Auch ihr Fehlen kann sich negativ auf die CTR auswirken. Optimierte -Tags und Meta-Beschreibungen müssen die Hauptkeywords enthalten, die richtige Länge haben und Duplikate vermeiden. Zwei oder mehr Seiten mit identischen Titeln und Beschreibungen erschweren es den Suchmaschinen, die Relevanz und damit auch das Ranking richtig zu bestimmen.

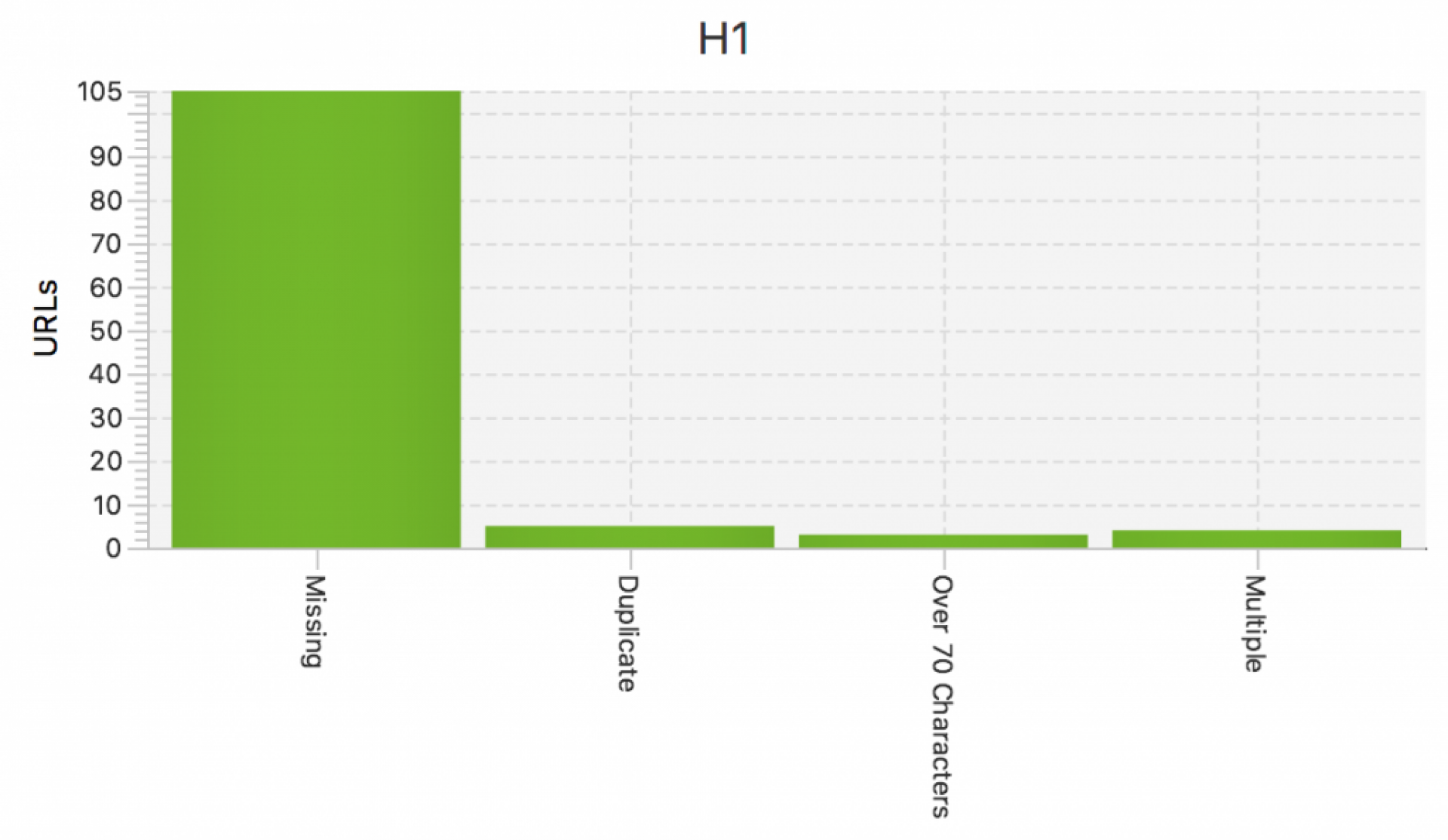

5. Die H1- Überschrift wird nicht korrekt verwendet

Ein Fehler, den viele machen, besteht darin, dass sie auf einer bestimmten Webseite mehr als einen H1-Tag verwenden. Dies ist für die Suchmaschinen-Bots verwirrend. H1-Tags können Ihre Rankings verbessern, deshalb darf diese Überschrift nicht fehlen und sollte nur einmal auf der Seite vorkommen. Ihr H1-Tag sollte sowohl Ihren Lesern als auch den Suchmaschinen helfen zu verstehen, worum es auf der Seite geht, deshalb ist eine Platzierung am Anfang des Seiteninhalts notwendig (über allen anderen H-Tags im Seiten-Quellcode). Stellen Sie sicher, dass Ihre Seiten eine H1-Überschrift besitzen und diese das jeweils wichtigste Keyword für diese Landingpage beinhalten. Achten Sie zudem darauf, dass das Hauptkeyword möglichst vorn in der H1-Überschrift steht.

6. Mehrere Seiten werden auf das gleiche Thema optimiert

Die Erstellung mehrerer Inhaltsteile, die auf genau dasselbe Keyword abzielen, ist ein sicherer Weg, dem eigenen Erfolg im Weg zu stehen. Mit mehreren Landingpages, die auf denselben Begriff abzielen, verwirren Sie Suchmaschinen-Bots bei der Identifikation der Seite mit der besten Antwort auf eine konkrete Anfrage. Dies könnte dazu führen, dass – zugunsten konkurrierender Websites mit einer klaren Antwort auf die konkrete Anfrage – keiner Ihrer Inhalte in den Top 10-Suchergebnissen erscheint. Bestimmen Sie hier durch die Analyse von Rankingdaten, welche Ihrer Seiten die beste Antwort für diese bestimmte Frage ist. Welcher Beitrag besitzt die größte Menge an organischem Traffic für Ihr Ziel-Keyword und entspricht am ehesten der damit verbundenen Suchabsicht? Sobald Sie Ihre Zielseite bestimmt haben, können Sie den bestehenden Inhalt dieser URL bewerten und besser auf das konkrete Keyword optimieren. Somit vermeiden Sie interne Kannibalisierung von Rankings und Duplicate Content, der im anderen Fall mit großer Wahrscheinlichkeit entstehen kann.

7. Duplicate Content

Duplicate Content innerhalb des Portals bedeutet, dass ähnlicher Inhalt an mehreren Stellen einer Website erscheint, und in der Folge wissen Suchmaschinen nicht, welche URL in den Suchergebnissen angezeigt werden soll. Dies kann dem Ranking einer Webseite schaden. Vermeiden Sie daher doppelte Beschreibungen, Absätze und ganze Textabschnitte, doppelte H1-Tags auf mehreren Seiten und URL-Konflikte, wie z. B. www- und Nicht-www-Versionen derselben Seite. Achten Sie auf die Einzigartigkeit jedes Details, um sicherzustellen, dass eine Seite nicht nur aus der Perspektive von Google optimiert ist, sondern auch in den Augen der Nutzer anklickbar ist. Anstatt zu versuchen, Ihre Seiten zu duplizieren, konzentrieren Sie sich darauf, Seiten mit wertvollem Inhalt zu erstellen, die mehr Chancen auf ein eigenes Ranking haben.

8. Verwendung eines 302- anstelle von 301-Redirects

Für einen Benutzer besteht kein Unterschied zwischen 301- und 302-Redirects. Suchmaschinen jedoch erkennen die verschiedenen Arten von Weiterleitungen und behandeln sie unterschiedlich. Eine 301-Weiterleitung bedeutet, dass die Seite dauerhaft an einen neuen Ort verschoben wurde. Eine 302-Umleitung signalisiert hingegen, dass der Umzug nur vorübergehend ist. Suchmaschinen müssen herausfinden, ob die alte Seite beibehalten oder durch die am neuen Standort gefundene Seite ersetzt werden soll. Wurde die falsche Umleitung eingerichtet, indizieren die Suchmaschinen möglicherweise weiterhin die alte URL und ignorieren die neue als Duplikat, was zu einem Trafficverlust führen kann. Deshalb ist es wichtig: Wird eine Website dauerhaft verschoben, muss ein 301-Redirect verwendet werden, nicht der 302-Redirect.

9. Fehlerhafte hreflang-Attribute

hreflang-Attribute sollen Querverweise auf Seiten herstellen, die inhaltlich ähnlich sind, aber unterschiedliche internationale Zielgruppen ansprechen. Mit dem Attribut hreflang können Sie verschiedene Zielgruppen je nach ihrer Sprache und/oder ihrem Land ansprechen. Auf diese Weise wird sichergestellt, dass die richtigen Seiten den richtigen Nutzern angezeigt werden. Hreflang-Fehler haben schwerwiegende negative Auswirkungen auf die internationale Ausrichtung und Platzierung einer Website in den Suchergebnissen. Ein Fehler ist z. B. kein auf sich selbst verweisendes hreflang-Tag. Innerhalb der hreflang-Tags ist es wichtig, dass jede Seite einen auf sich selbst referenzierenden hreflang-Code besitzt. Auch fehlerhafte hreflang-Angaben stellen ein großes Problem dar. Wenn Sie hreflang-Codes zu Ihren Webseiten hinzufügen, vergewissern Sie sich, dass Sie die richtigen Länder- und Sprachcodes verwenden. Laut Google muss der Wert des hreflang-Attributs für die Sprache im Format ISO 639-1 und für die Region im Format ISO 3166-1 Alpha 2 vorliegen. Suchmaschinen erkennen eine internationale Website nicht und ordnen sie nicht richtig ein, wenn das angegebene Land oder die Sprache nicht diesen Formaten entspricht. Ein häufiger Fehler ist zum Beispiel die Verwendung von “uk” für Vereinigtes Königreich anstelle des korrekten Codes “gb”.

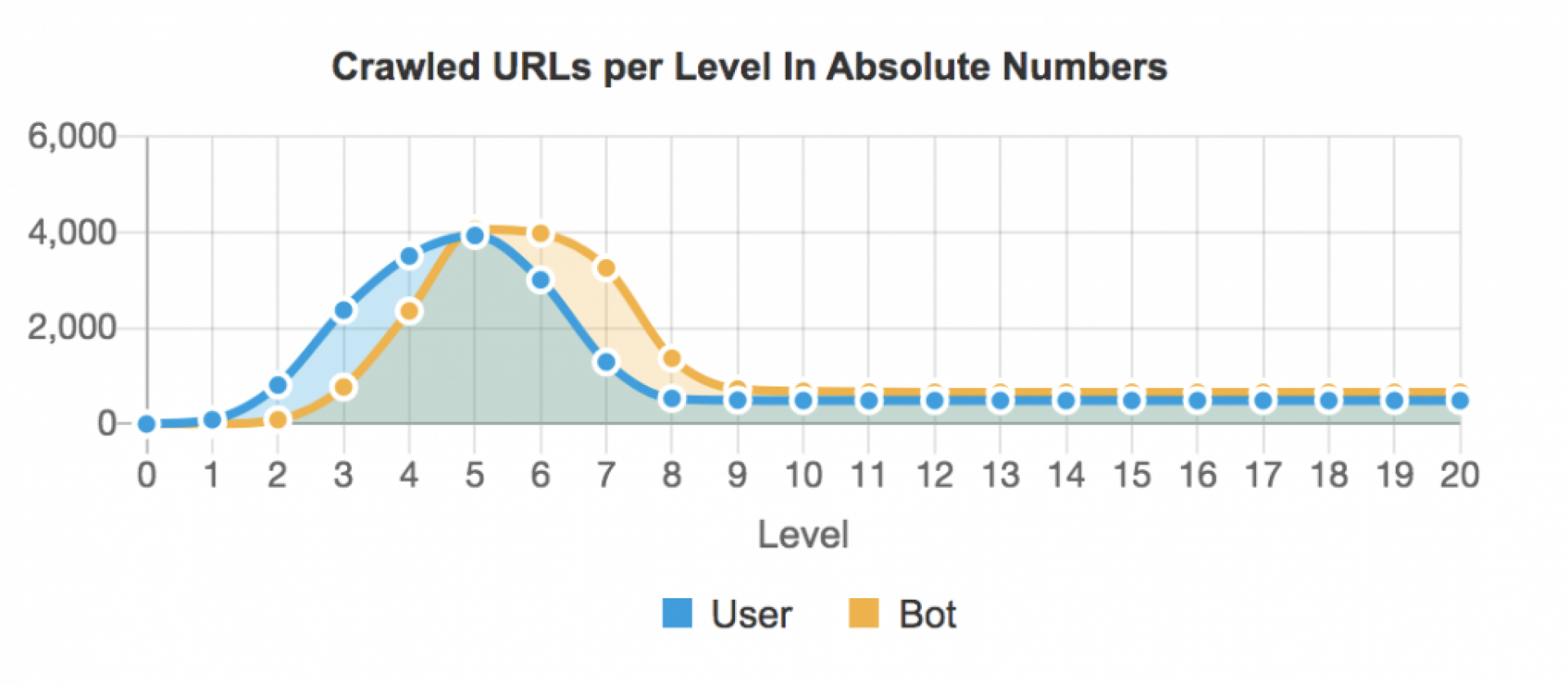

10. Schlechte interne Verlinkung

Inhalte werden durch Links entdeckt. Die interne Verlinkungsstruktur Ihrer Website teilt den Bots (und den Benutzern) mit, welche Seiten am wichtigsten sind und welche Seiten für bestimmte Keywords am relevantesten sind. Je mehr eingehende interne Links eine Seite hat, desto höher ist die Chance, dass Benutzer und Crawler sie finden. Setzen Sie deshalb mehr eingehende Links zu den Seiten mit wichtigem Inhalt und stellen Sie gleichzeitig sicher, dass die verlinkten Seiten füreinander relevant sind. Vergessen Sie in Ihrer Verlinkungsstrategie die Crawl-Tiefe nicht. Sie fasst die Anzahl der Klicks zusammen, die erforderlich sind, um eine Seite von der Homepage aus zu erreichen. Je mehr Klicks erforderlich sind, desto unwahrscheinlicher ist es, dass Crawler und Benutzer die Seite erreichen. Wichtige Seiten, die mehr als 3 Klicks von der Homepage entfernt sind, sind schlecht für SEO und für Ihre Besucher. Stellen Sie Ihre interne Link-Architektur so um, dass die wichtigen Inhalte mit möglichst wenigen Klicks erreicht werden können.